北条麻妃出租车

小色哥萝莉网 1行代码矫合法模子西宾,Llama西宾速率升至1.47倍,华东谈主团队出品

克雷西 发自 凹非寺小色哥萝莉网

量子位 | 公众号 QbitAI

惟有改一瞥代码,就能让大模子西宾遵循普及至1.47倍。

领有得州大学奥斯汀分校配景四名华东谈主学者,提倡了大模子西宾优化器Cautious Optimizers。

在提速的同期,Cautious约略保证西宾遵循不出现示寂,而且谈话和视觉模子都适用。

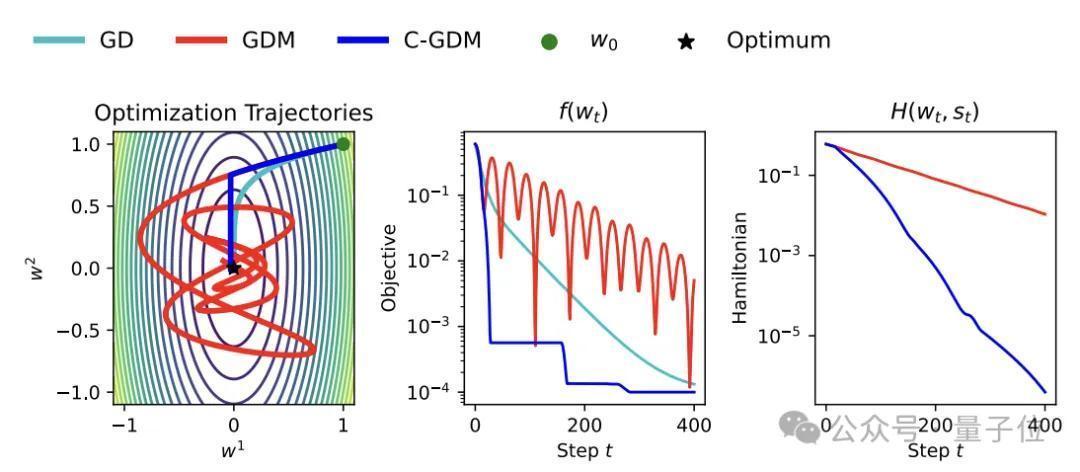

该优化器以哈密顿量和着落能源学为表面基础,在加快的同期不影响不休特色。

作家在600M到1B不同参数规模的Llama模子上进行了磨砺,得回了最高47%的加快率。

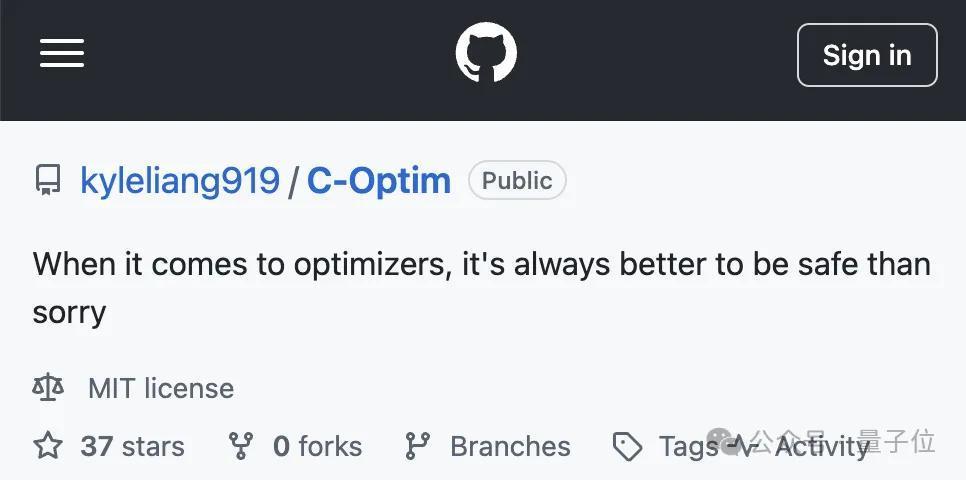

该有计划联系代码也曾开源,在GitHub上有使用步调的提神老师。

一瞥代码矫合法模子西宾

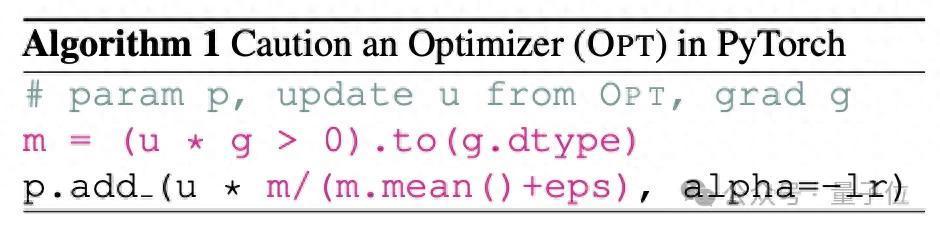

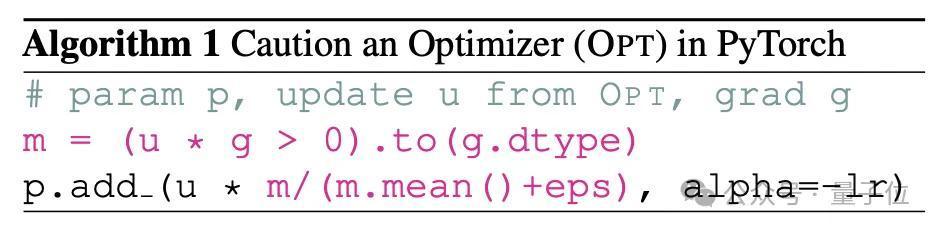

Cautious Optimizers在PyTorch当中增多的一瞥代码,中枢念念路是引入杀青一种躲闪机制,从而幸免参数更新的标的与现时梯度标的各异。

因为这两个标的一朝不一致,就有可能导致示寂函数暂时增多,形成不休速率的减缓。

自拍偷拍不外作家并未在标的不一致的开首问题上过度纠结,而是引入了一种判断机制,在参数更新之前增多一步盘算推算,从而过滤掉标的不一致的情形。

这也恰是上头代码的径直作用。

△GD:梯度着落,GDM:带动量的梯度着落,C-GDM:本名堂

具体来说,加入的两行代会对u和g两个向量求内积,u向量对应优化器给出的参数更新标的,而g向量对应现时本领的梯度标的。

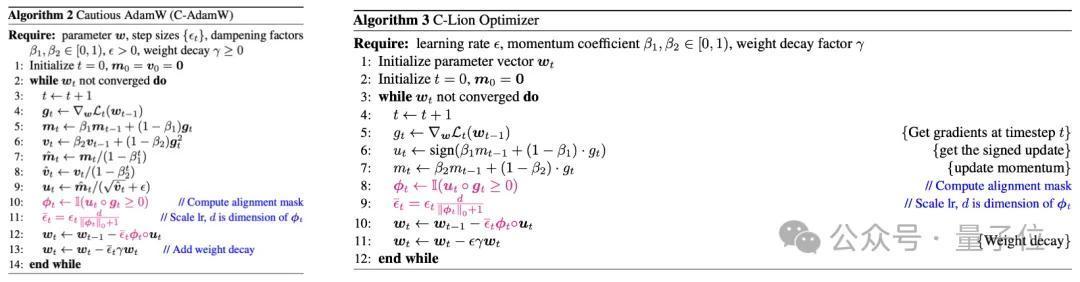

作家设想了一个对皆掩码函数ϕ,当u和g的内积小于0时(即标的不一致),ϕ的输出为0向量;当内积大于即是0时,ϕ的输出为全1向量。

而一朝ϕ为零向量时,w_t盘算推算式中含u的项也会变为零向量,导致此项更新被跳过。

这么就不错判断参数更新和梯度标的是否一致,要是不一致则不会用于参数更新,幸免了西宾流程中示寂函数的回升。

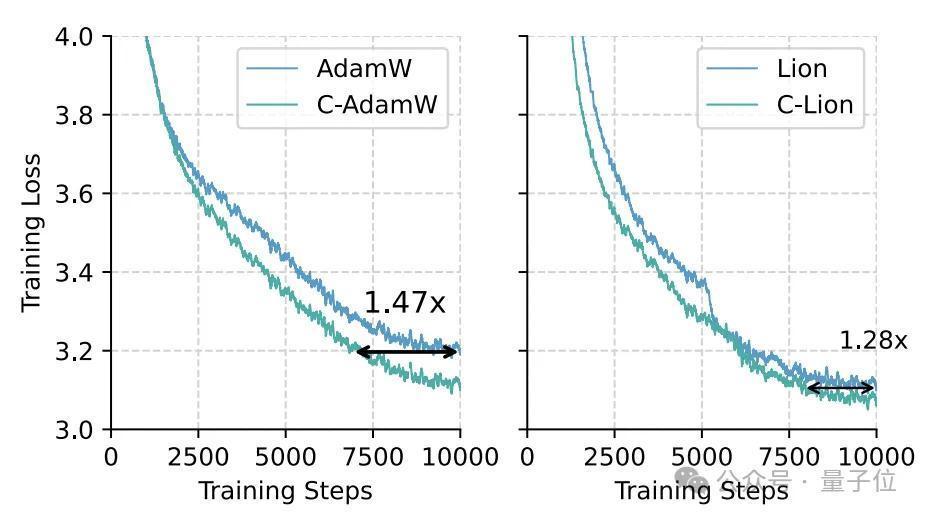

西宾遵循普及47%为了评估Cautious Optimizers的具体遵循,作家辩认在谈话模子Llama和视觉模子MAE上进行了磨砺。

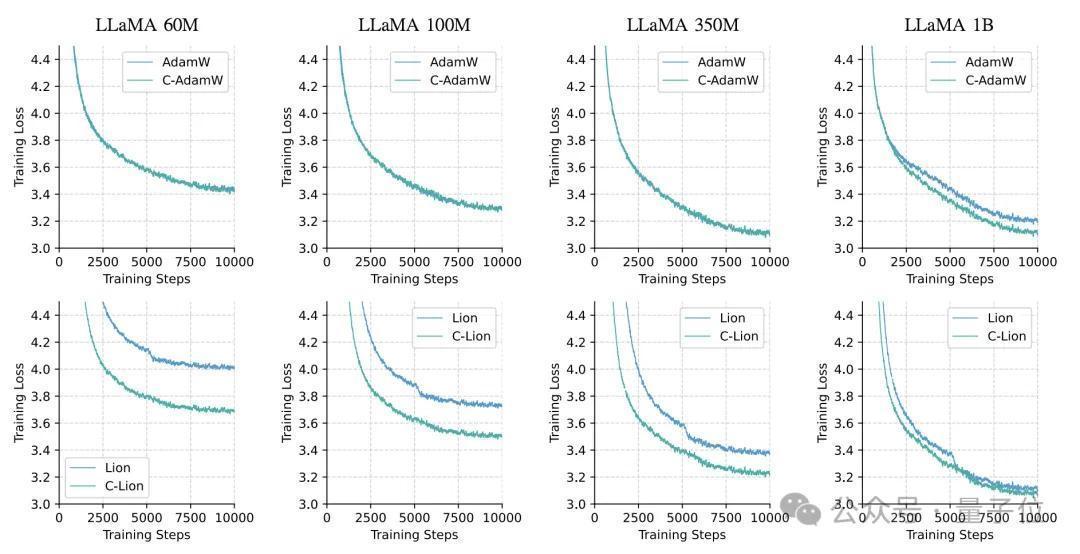

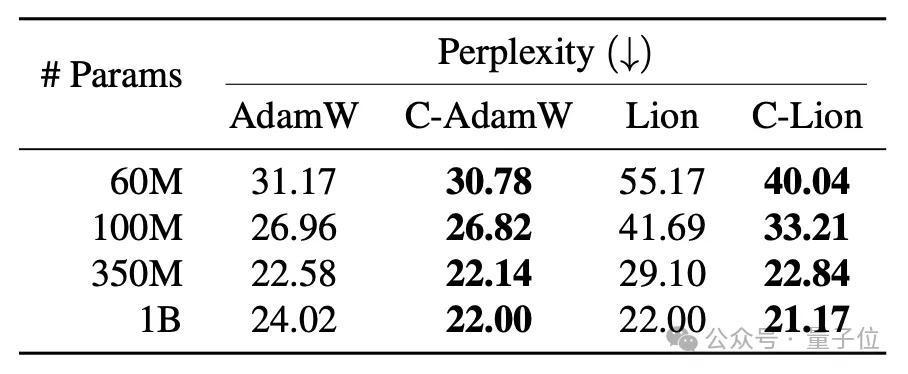

作家中式了60M、100M、350M和1B四种参数规模的Llama模子,在C4语料库上进行预西宾。

优化器接管了AdamW和Lion,以及它们对应的Cautious版块:C-AdamW和C-Lion,每个践诺中进行1万步迭代。

国法C-AdamW和C-Lion在统共规模上都发达出明显的不休加快遵循。

尤其是在1B规模上,比拟原版的AdamW和Lion,它们的样本遵循辩认提高了47%和28%,这标明Cautious Optimizer能灵验减少西宾震憾,使不休更肃肃高效。

何况,Cautious Optimizer在统共情况下都取得了更低的困惑度,印证了其出色的泛化性能。

为了评估模子的本色遵循,有计划者在语句匹配、文本蕴含、边幅分类等6个GLUE下贱任务上测试了AdamW和C-AdamW优化后1B模子的发达,

国法标明,C-AdamW的平均得分比AdamW高出2%,在大多量任务上都取得了高出,讲解Cautious跳过部分参数更新的时势不会引起模子性能着落。

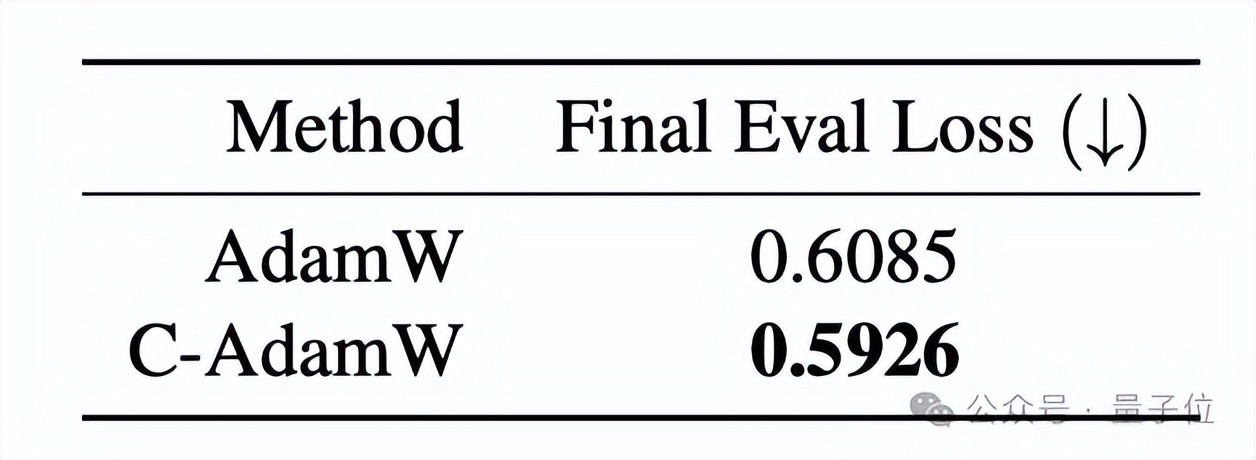

关于视觉模子,作家以ViT为主干汇注,在ImageNet-1K数据集上预西宾了MAE模子。

由于视觉任务的突出性,西宾流程接受了立地陡立图像块并重建的范式,因此优化运筹帷幄是最小化重建曲折,而非时时的分类示寂。

作家对比了AdamW和C-AdamW的发达,即西宾50轮后的最终重建曲折,国法C-AdamW的曲折为0.5926,低于AdamW的0.6085。

一作曾在一周内复刻o1

本名堂是由四名华东谈主学者共同打造的。

第一作家Kaizhao Liang,是AI推理加快管事商SambaNova公司的别称高档ML工程师。

在o1模子发布一周内,该公司就推出了一个肖似o1模子念念考流程的开源平替,主要作家恰是Liang。

其他三名作家是得州大学奥斯汀分校CS助理涵养Qiang Liu,以及他的两名博士生,Lizhang Chen和Bo Liu。

此外,Liang的东谈主工智能硕士学位亦然从该校得回。

论文地址:

https://arxiv.org/abs/2411.16085GitHub:https://github.com/kyleliang919/C-Optim— 完 —

量子位 QbitAI · 头条号签约

爱护咱们小色哥萝莉网,第一本领获知前沿科技动态